用于研发万亿级大语言模型!英伟达发布DGX GH200

添加书签

专注AIGC领域的专业社区,关注GPT-4、百度文心一言、华为盘古等大语言模型(LLM)的发展和应用落地,以及国内LLM的发展和市场研究,欢迎关注!

5月29日,NVIDIA(英伟达)发布了主要用于生成式AI、大语言模型、AI应用、推荐系统、数据处理等研发的超级计算机——DGX GH200。

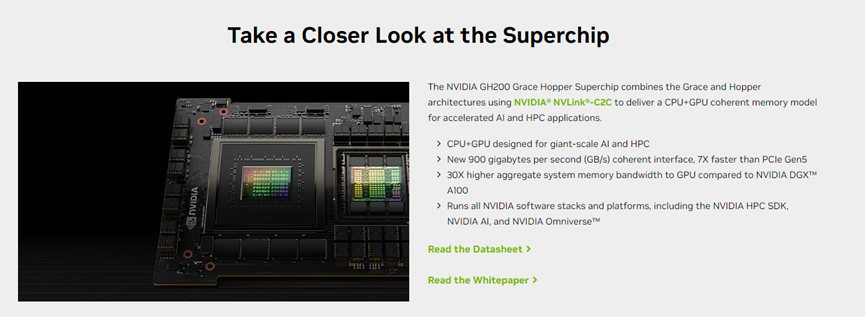

据悉,DGX GH200由超级芯片NVIDIA® GH200 Grace Hopper和NVIDIA NVlink组成。

DGX GH200提供的共享内存达到了惊人的144 TB!内存比2020年推出的上一代 NVIDIA DGX A100多近500倍,可帮助研发人员更快地研发万亿级模型。

NVIDIA创始人兼首席执行官黄仁勋表示,生成式AI、大型语言模型和推荐系统是数字化经济时代的重要引擎。DGX GH200集成了NVIDIA目前最先进的软硬件技术,支持开发人员研究更强大的AI模型。

目前,微软与谷歌展开的“生成式AI军备赛”席卷全球,各行业开始纷纷开始将ChatGPT、Midjourney等生成式AI,应用在实际业务中加速数字化转型实现降本增效,同时对算力有着巨大需求。

NVIDIA作为全球最大的AI算力供应商几乎垄断了该行业。受生成式AI风口利好影响,目前NVIDIA的市值达到9600亿美元,有望成为芯片领域第一家突破万亿美元市值的企业。

据悉,DGX GH200采用的超级芯片与NVIDIA DGX™ A100 相比,GPU的总系统内存带宽高出30倍;新型900 GB/s一致性接口,比PCIe5.0快7倍。可运行所有NVIDIA软件堆栈和平台,包括NVIDIA HPC SDK、NVIDIA AI 和 NVIDIA Omniverse™等。

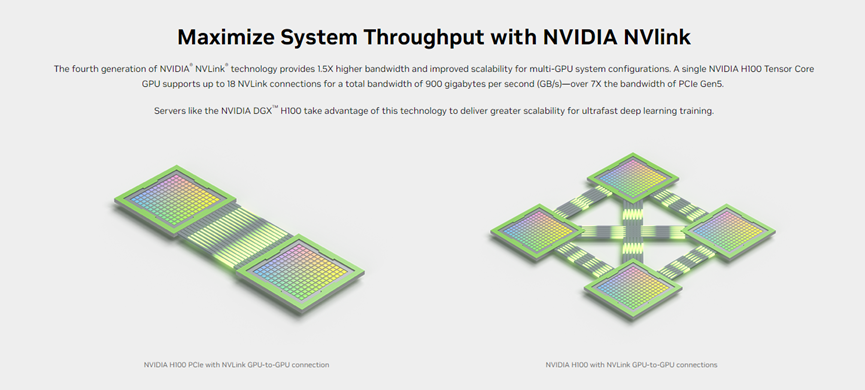

NVIDIA NVlink是一种GPU互联技术,旨在解决传统PCI Express互联所面临的带宽和延迟限制问题,提高GPU与CPU之间的通信性能,从而可以跨节点扩展,以创建无缝、高带宽、多节点的 GPU集群。

DGX GH200的架构比上一代的NVlink带宽强大了48倍,同时支持系统中的所有GPU协同工作。

微软、谷歌云和Meta(脸书母公司)是首批有望使用DGX GH200 探索生成AI能力的企业。

NVIDIA还打算将 DGX GH200 设计作为蓝图提供给云服务提供商和其他超大规模服务商,以便可以根据自己的基础设施进一步量身定制。DGX GH200预计将于今年年底上市。

微软 Azure副总裁 Girish Bablani表示,传统上,训练大型AI模型是一项消耗大量资源和时间的密集型任务。开发人员借助DGX GH200处理TB级数据集的能力,能以更大规模和更快的速度进行高级研究。

本文素材来源NVIDIA官网,如有侵权请联系删除

END

「AIGC开放社区」ChatGPT对话机器人大合集,扫描二维码免费使用