MIT与谷歌最新研究DragGAN:无损图像精确控制技术的重大突破

添加书签

专注AIGC领域的专业社区,关注GPT-4、百度文心一言、华为盘古等大语言模型(LLM)的发展和应用落地,以及国内LLM的发展和市场研究,欢迎关注!

5月20日,马克斯普朗克研究、麻省理工计算机与AI实验室、via-center、宾夕法尼亚大学和谷歌等联合发布了一篇名为《Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifold》的论文。根据其Github主页显示,预计6月进行开源。

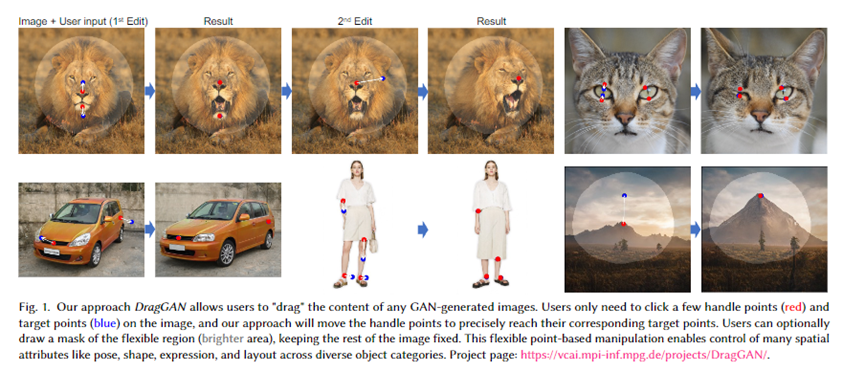

该论文提出了一种控制GAN的新方法 DragGAN,使用户能以无损的方式拖动几下鼠标就能改变图像形态。例如,将一张严肃的脸,拖动几下鼠标就能变成微笑的形态;将一匹站立的马,更改成奔跑形态等。

简单来说,DragGAN的功能与Photoshop的“液化”功能差不多,但比其更加强大、精准、易使用,尤其是DragGAN提供了可视化操作界面,即便不懂编程的人员也能快速上手使用。

目前,Midjourney等文生图产品无法精准表达用户想要的效果,想应用在实际业务中需要用Photoshop、Illustrator、C4D等专业设计软件进行大量更改。如果将DragGAN与Midjourney等一起使用,可以在无损的情况下进行精准更改,使得普通人也能成为专业设计师。

Github地址:https://github.com/XingangPan/DragGAN

项目展示:https://vcai.mpi-inf.mpg.de/projects/DragGAN/

论文地址:https://arxiv.org/abs/2305.10973

DragGAN在基于GAN的图像处理领域取得了重大进步。该方法利用预训练的GAN生成紧密遵循用户输入且保持真实感的图像。通过优化潜在编码和点追踪过程,DragGAN提供像素级精确的图像变形和交互式性能。

DragGAN主要由两大部分组成:基于特征的运动监控和新型点追踪方法。运动监控允许用户引导图像中手柄点向目标位置移动;点追踪方法利用显著的生成器特征,来跟踪手柄点在移动过程中的位置。

因此,用户可以精确地改变动物、汽车、人类和风景等图片的,姿势、形状、表情、布局等属性。

DragGAN效果展示

相比传统方法,DragGAN提供了一种更灵活、精确和通用的控制GAN的方式,允许用户在图像上选择任意数量的手柄点和相应的目标点,通过移动这些手柄点以达到目标,允许用户控制一系列空间属性,而不管对象类别。

此外,DragGAN提供的方法不依赖于任何其他网络,例如,RAFT,可以能够高效地执行操作任务。从论文内容来看,DragGAN使用RTX 3090 GPU 只需几秒钟就能完成效果。在少量算力资源的情况下,允许用户进行实时的交互式图片编辑,从而能够快速迭代不同的图像布局。

在无损优化方面,DragGAN 的一个关键特征是它能够让用户输入二进制掩码,指示图像中的可移动区域。这允许对操作进行更细致的控制,有助于减少歧义并保持某些区域的固定属性。

如果使用传统的Photoshop的液化功能,将会对图片的原属性进行损坏,无法达到更好的融合效果。

根据DragGAN的展示效果来看,其应用范围非常广泛,例如,改变图片中一辆车的轮胎形状,改变车辆的位置,改变车辆的大小,点几个锚点拖动几下鼠标就能轻松完成。

不过研究人员也对DragGAN提出了担忧,未来开源后大量应用在实际业务中,希望不会应用在非法业务中,例如,侵害个人肖像权,通过改变图片形态进行造假等。

本文素材来源DragGAN,如有侵权请联系删除

END

「AIGC开放社区」ChatGPT对话机器人大合集,扫描二维码免费使用