OpenAI再失一名高管,6年AGI顾问宣布离职

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

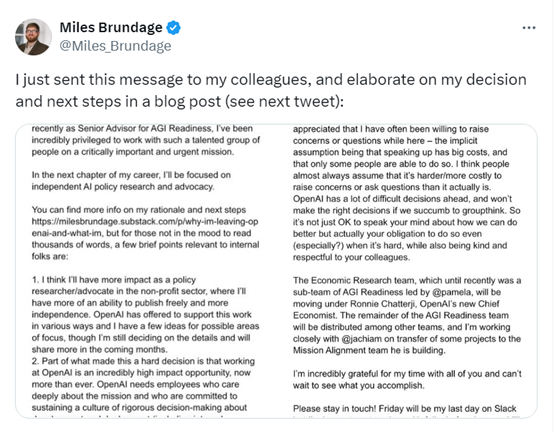

OpenAI高级AGI研究顾问Miles Brundage宣布离开OpenAI。

Brundage于2018年加入OpenAI,曾担任多个重要职务包括研究科学家、政策研究负责人以及高级AGI顾问,主要工作是确保OpenAI的产品能以安全、可靠的方式进行部署使用。

在OpenAI工作期间,Brundage领导了外部红队计划,通过模拟攻击来测试OpenAI的AI系统的安全性和鲁棒性。此外,还推动了OpenAI的“系统卡”报告的创建,这些报告详细记录了AI模型的能力和局限性,为公众和研究者提供了重要的透明度。

在政策研究方面,Brundage 对ChatGPT的负责任部署、使用发挥了重要作用。还积极参与了有关AI进展评估、AI安全监管、AI经济影响以及有益AI应用加速推进等方面的研究。他提出的“AI大战略”概念,旨在制定确保人工智能广泛造福人类的框架。

在加入OpenAI之前, Brundage曾在牛津大学的未来人类研究所工作,在那里他专注于AI政策和治理问题。他的学术背景包括公共政策和科学技术研究,这为他在AI政策领域的工作奠定了坚实的基础。

Brundage发表了一篇万字长文详细阐述了为什么离开OpenAI以及接下来想做点什么。主要原因之一是,他想在非营利部门作为研究人员和倡导者产生影响,在那里拥有更多的发表自由。

Brundage表示,在OpenAI的角色让他有机会对公司的发展和部署提供建议,但随着时间的推移,感到在行业外部进行政策研究可能会更有效。他想创立一个新的非营利组织或加入现有的非营利组织,并将从事人工智能政策研究和宣传工作。

他的研究兴趣包括评估和预测AI进展、前沿AI安全的监管问题、AI的经济影响、有益AI应用的加速推进和计算治理。

目前,Brundage已经完成了在OpenAI计划要做的大部分工作,并且他认为可以在外部更有效地推动某些政策工作。他强调,尽管他离开了OpenAI,但他对公司的使命仍然持乐观态度,并相信某些政策工作可能在行业外进行更为有效。

在谈到OpenAI和世界对AGI准备情况时,Brundage认为,无论是OpenAI还是任何其他前沿实验室,以及世界本身都还没有准备好。这与公司和世界是否在朝着做好准备的方向前进是不同的问题,在安全文化、监管对组织激励的影响、AI能力和安全难度的各种事实等方面的发展将影响AGI准备情况。

Brundage表示,AI能力正在迅速提高,政策制定者需要更紧迫地采取行动。想让AGI惠及全人类不是简单的事情,需要政府、非营利组织、民间社会和行业的决策者做出深思熟虑的选择,并且需要激烈的公众讨论谨慎执行。

目前,OpenAI尚未公布谁将接替Brundage所负责的工作。

本文素材来源Miles Brundage,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区