谷歌提出视觉记忆方法,让大模型训练数据更灵活

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

目前,多数大模型一旦经过预训练,其内部结构便难以改变,就像把知识刻在石头一样。如果你想对模型的数据进行更新,就需要对整个模型重新训练,消耗大量时间和AI算力。

为了解决这一难题,谷歌DeepMind的研究人员提出了创新视觉记忆技术,其核心是将深度学习模型的表示能力与数据库的灵活性相结合,可以灵活地添加或删除数据。简单来说,和人类的视觉记忆差不多,既能不断学习新的知识,又能对已有的知识进行更新和调整。

构建视觉记忆的过程主要有两个步骤:首先建立视觉记忆,然后利用快速最近邻检索进行分类。视觉记忆本质上是一个存储了图像及其对应标签的数据库,其中每张图片都被映射到一个高维嵌入空间。

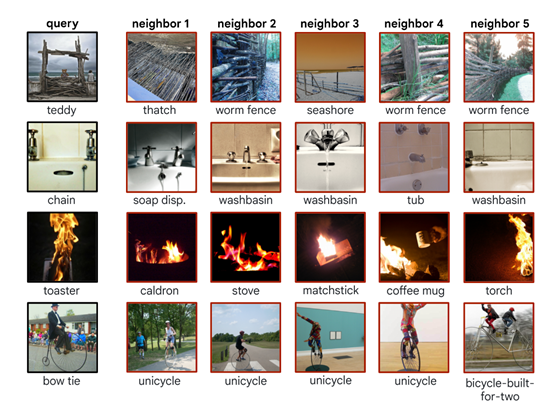

当接收到一个新的查询图像时,系统会计算其与内存中所有图像之间的距离,并返回最接近的几个邻居作为候选答案。接下来,通过对这些候选答案进行加权投票来确定最终分类结果。

在构建视觉记忆的第一步中,从一个图像数据集中提取(图像,标签)对,并使用一个固定的预训练图像编码器来提取特征映射。这些特征映射和对应的标签对被存储在一个数据库中,形成了用于分类的视觉记忆。这种方法的一个关键优势在于,它不需要在添加信息到视觉记忆时进行额外的训练,可以快速地将新的知识整合到模型中,而不需要重新训练整个神经网络。

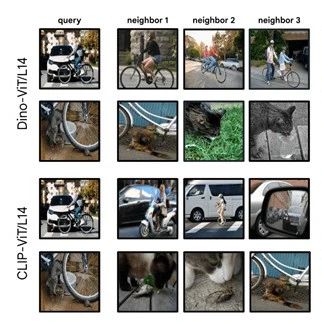

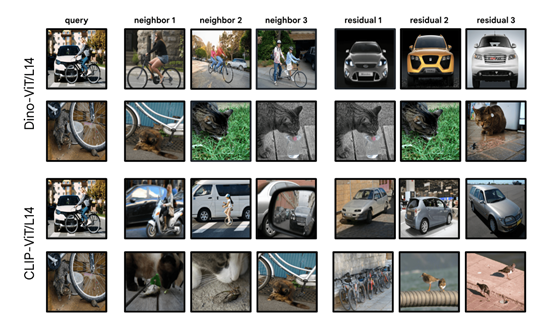

特征提取是构建视觉记忆的关键环节之一。在这个过程中,使用DinoV2、CLIP预训练的图像编码器将图像映射到一个特征空间中,其中相似的图像在特征空间中的距离也相近。通过这种方式,可以为每个图像生成一个特征向量,这个向量捕捉了图像的关键信息,并为后续的相似性搜索提供了基础。

一旦有了这些特征向量,我们就可以构建一个数据库,其中包含了图像的特征向量和对应的标签。这个数据库就是我们的视觉记忆,它存储了模型所“知道”的所有信息。当需要对一个新的查询图像进行分类时,系统会提取该图像的特征向量,并在视觉记忆中寻找与之最相似的图像。

在视觉记忆建立之后,下一步就是利用这个记忆进行快速的最近邻搜索,以辅助图像分类。给定一个查询图像,系统首先提取其特征向量,然后在视觉记忆中搜索与之最相似的特征向量。这些相似的特征向量被称为“邻居”,按照与查询图像的距离进行排序。最近的邻居被认为是与查询图像最相似的图像,因此在分类决策中具有最高的权重。

例如,如果我们想让模型识别新的物体类别数据,可以简单地将这些新类别的图像特征向量和标签添加到视觉记忆中,模型就能够在不重新训练的情况下,立即使用这些新信息进行分类决策。

除了能灵活添加数据之外,还能快速删除特定数据,主要通过机器反学习来实现。机器反学习可以通过简单地从数据库中删除对应的(图像,标签)对来实现。这样,当模型再次进行分类决策时,这些被删除的数据就不会被考虑在内。

例如,如果我们发现某个数据样本包含有偏见或不准确的信息,我们可以将其从视觉记忆中删除,以确保模型的决策不受这些数据的影响。

为了进一步优化视觉记忆,研究人员还引入了“记忆剪枝”方法,通过识别并移除或降低低质量样本的影响来实现优化。

记忆剪枝的过程涉及到对视觉记忆中的每个样本进行评估,以确定它们对分类决策的贡献。这可以通过分析样本在训练集上的表现来实现,例如,通过计算样本在分类决策中导致错误的次数。那些导致错误次数较多的样本可能被认为是低质量的,因此可以被移除或降低权重。

论文地址:https://arxiv.org/pdf/2408.08172

本文素材来源谷歌,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区