谷歌发布新RL方法,性能提升巨大,o1模型已证明

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

谷歌DeepMind的研究人员提出了一种创新多轮强化学习方法——SCoRe。

目前,多数大模型不具备自我纠错或能力较差,尤其是在数学和代码领域在给出错误答案后,会一直坚持错误答案,影响模型的准确率。而SCoRe通过避免训练数据与模型实际响应分布不匹配以及多轮反馈奖励机制,来帮助大模型及时纠正自己的错误。

OpenAI最近发布的o1模型便使用了类似的技术,主要亮点之一便是模型的自我纠错能力,其数学和代码能力也获得了大幅度提升。也就是说,强化学习确实能帮助大模型提升输出性能和准确率。

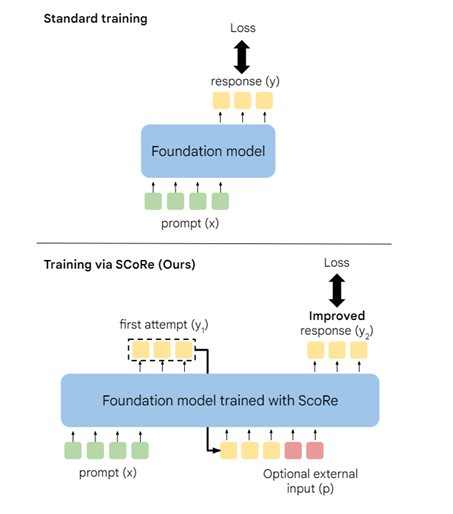

在传统的大模型训练过程中,模型通常通过监督学习来优化其对特定任务的性能。但这种方法主要依赖于大量的标注数据,并且在训练和推理之间存在巨大的数据分布差异,导致模型在实际应用中难以有效纠正错误。

例如,在图像识别任务中,模型在训练时主要使用的是风景领域的图像,并且对这些图像的标注信息进行了学习。但在实际应用中,遇到一些与训练数据差异较大的图像,光照条件不同、拍摄角度不同以及具备不同物体特征的医学图像时。模型可能就会无法识别这些新图像,并且难以通过自我纠正来改进性能。

最重要的是,传统的监督学习方法在训练过程中,并没有明确地教导模型如何自我纠正错误。一旦模型在推理阶段产生错误的结果,只能依赖外部反馈或手动干预来纠正这些错误。这对于需要高度准确率的法律、金融等应用场景来说是一个重大缺陷。

而SCoRe则是在模型自己生成的数据上进行多轮强化训练,使模型能够学习到如何根据奖励信号来调整自己的输出实现自我纠正。

在训练过程中,SCoRe 会鼓励模型尝试不同的输出,并根据奖励信号来判断哪些输出是最准确的。帮助模型就能够逐渐学习到如何在不同的情况下做出正确的决策。

例如,在文本生成任务中,如果模型生成的句子不符合语法或是病句,SCoRe 会给予模型一个负面的奖励信号,促使模型调整自己的输出直到生成符合要求的句子。

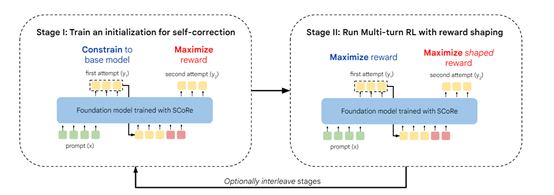

SCoRe的强化学习方法主要分为两大阶段:在第一阶段,SCoRe通过强化学习对基础模型进行初始化训练。目标是训练模型在第一次尝试时产生高质量的回答,并在第二次尝试时能够对第一次的回答进行有效的纠正。为了实现这一目标,研究人员会在模型的输出上施加一种正则化约束,以避免模型在第一次尝试中产生与基础模型差异过大的回答。

这种约束通过计算模型输出与基础模型输出之间的KL散度来实现。通过调整KL散度的权重,可以在保持模型第一次尝试质量的同时,鼓励模型在第二次尝试中进行更大胆的纠正。

在模型初始化训练完成后,SCoRe进入第二阶段多轮强化学习与奖励塑造。在这一阶段,模型在每一轮尝试中都会接收到一个奖励信号,该信号基于模型当前尝试与正确答案之间的匹配程度。通过最大化这些奖励信号,模型可以逐步学习如何改进其答案。

为了进一步引导模型学习有效的自我纠正能力,研究人员为模型在第二次尝试中正确纠正错误的行为提供了额外的奖励。

如果第二次尝试的响应从错误变为正确,那么这个奖励项会给模型较大的正奖励;如果第二次尝试将正确的响应变为错误,那么会给予模型严重的负惩罚。

这样的奖励塑造使得模型更倾向于学习到自我纠正的策略,因为那些没有改变响应正确性或导致崩溃的轨迹对整体损失的贡献较小。

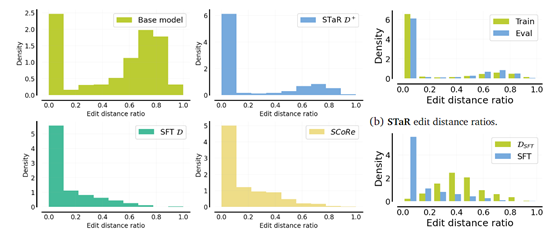

为了验证SCoRe的性能,研究人员在谷歌自研的Gemini 1.0 Pro和Gemini 1.5 Flash两款大模型进行了数学和代码测试。结果显示,其自我纠正能力分别提升了15.6%和9.1%。

本文素材来源SCoRe论文,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区