Mistral开源首个多模态大模型—Pixtral 12B

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

法国著名开源大模型平台Mistral AI开源了,首个能够同时处理图像和文本的多模态大模型——Pixtral 12B。

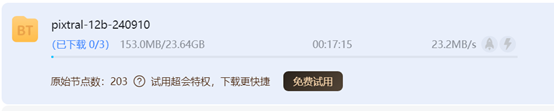

Mistral AI开源的方式依然非常简单粗暴,直接上磁力链接,把所有模型权重都放出来了。

「AIGC开放社区」已经试验了一下,大小在23.64G左右,这个在多模态模型中属于比较小的了,估计能耗和部署方面会方便很多。

下载速度也是满载状态,说明这个模型还是相当受欢迎。如果你是千M光纤,估计几分钟就下完了。

不少网友对Mistral AI开源的新模型相当满意,再一次拉动了大模型开源领域向多模态进军。

Mistral刚刚发布了一个24G的重磅炸弹,迫不及待想看看这个多模态野兽能干点啥啦。

据悉,Pixtral有120亿参数,是在Mistral的一个文本模型Nemo 12B基础之上开发而成,与Anthropic的Claude系列和OpenAI的GPT-4o等其他多模态模型类似,能理解、回答任意大小图像的问题。

架构方面,40层、14,336个隐藏维度大小和32个注意力头,配备了400M的专用视觉编码器,支持1024×1024图像尺寸和 24个隐藏层的高级图像处理。词汇量大,其词汇表中大约有 13万个独特的标记,可实现细致入微的语言理解和生成。

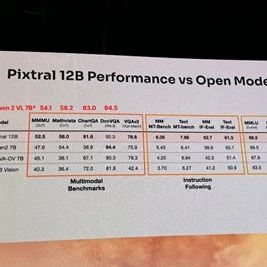

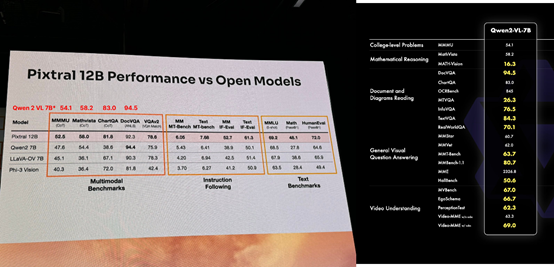

此外,根据数据评测显示,Pixtral 12B在MMMU、Mathvista、ChartQA、DocVQA基准测试平台的数据比Phi-3、 Qwen-2 7B等知名多模态模型更好。

模型权重下载地址:magnet:?xt=urn:btih:7278e625de2b1da598b23954c13933047126238a&dn=pixtral-12b-240910&tr=udp%3A%2F%http://2Ftracker.opentrackr.org%3A1337%2Fannounce&tr=udp%3A%2F%http://2Fopen.demonii.com%3A1337%2Fannounce&tr=http%3A%2F%http://2Ftracker.ipv6tracker.org%3A80%2Fannounce

huggingface地址:https://huggingface.co/mistral-community/pixtral-12b-240910

END

本篇文章来源于微信公众号: AIGC开放社区