开源疯狂内卷!媲美GPT-4o、支持中文,超Llama 3.1

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

昨天Meta刚开源Llama 3.1系列,今天法国著名开源大模型平台Mistral.ai就开源了Mistral Large 2,开源大模型实在是太卷了。

Mistral Large 2有1230亿参数,支持英语、中文、法语、德语、日文和韩文等十几种主流语言,这一点比Meta的Llama 3.1强很多,因为它是不支持中文的。

Mistral Large 2能生成文本、摘要、代码等,尤其是128K上下文窗口,在代码和数学推理方面进行了极大增强,支持Python、Java、C、 C++、JavaScript等几十种编程语言。

开源地址:https://huggingface.co/mistralai/Mistral-Large-Instruct-2407

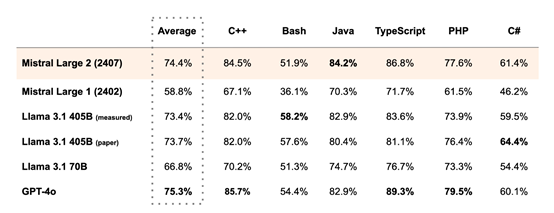

性能测试方面,Mistral.ai特意将Mistral Large 2与GPT-4o、Llama 3.1 405B、GPT-4等主流开闭源大模型进行了综合对比。

在 HumanEval 、MultiPL-E 等代码生成任务上,性能优于 Llama 3.1 405B并且得分略低于 GPT-4。在数学方面,特别是在MATH基准的零样本无思维链推理上,Mistral Large 2 排名第二,性能仅次于GPT-4o。

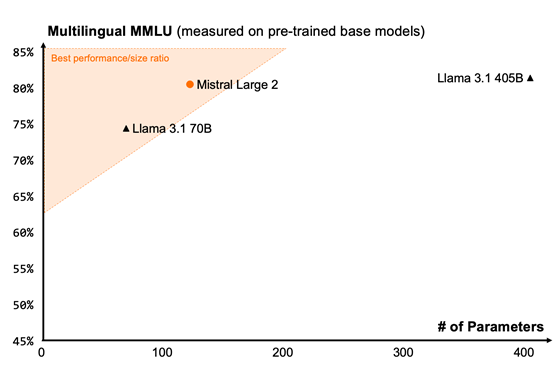

考虑到许多业务场景涉及多语言文档处理,而大多数模型都侧重于英语,Mistral Large 2在大量多语言数据上进行了广泛训练。特别是在英语、中文、法语、德语、西班牙语、意大利语、葡萄牙语、荷兰语、俄语、日语、韩语、阿拉伯语和印地语方面表现出色。

在性能方面,Mistral Large 2在多语言理解(MMLU)的预训练版本上达到了84.0%的准确率,超过Llama 3.1 70B等知名模型。

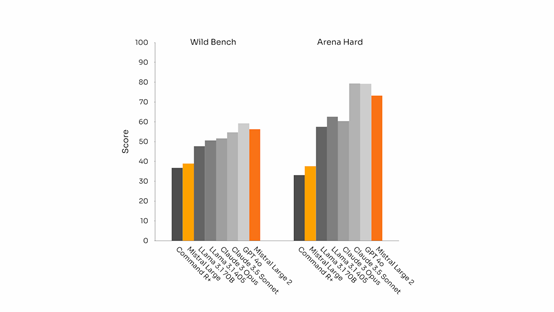

Mistral Large 2在遵循指令和处理长多轮对话方面也取得了显著进步,它在MT-Bench、Wild Bench和Arena Hard等基准测试上表现出色。

Mistral Large 2的设计初衷是为了单节点推理,特别是针对长上下文应用,其庞大的参数规模达到1230亿,能够在单个节点上实现高效的数据处理。此外,Mistral Large 2还配备了增强的功能调用和检索功能,能够熟练执行并行和顺序功能调用,帮助开发者打造强大的搜索引擎。

目前,Mistral.ai已经与谷歌云、亚马逊云、微软Azure等知名平台达成了技术合作关系,用户可以在这些平台上直接最新的Mistral Large 2模型。

本文素材来源Mistral.ai官网,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区