马斯克用10万块H100,搭建全球最强AI训练集群!

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

7月22日,马斯克在社交平台宣布,在美国孟菲斯凌晨4点20,在单个RDMA结构(远程直接内存访问)上搭建10 万块液冷H100 GPU,这也是目前全球最强的AI训练集群。

马斯克认为,截止到今年12月,从各项指标来看,这对于训练世界最强大的AI模型来说都是一个显著的优势。

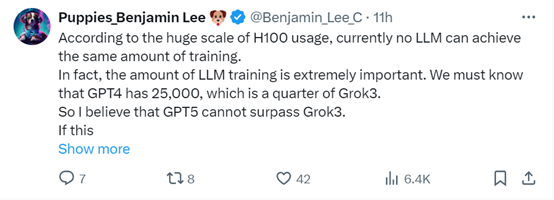

对于马斯克搭建全球最强AI训练集群的说法是否过于夸张,就有网友给出了解读。目前还有纯大模型平台使用10万块H100来搭建训练平台。

要知道OpenAI的GPT-4也只用了25,000块,马斯克最新搭建的训练平台可能会用于训练Grok3,所以,如果OpenAI不继续加码硬件设施,其未来发布的GPT-5可能不会超过Grok3。

拥有世界最强的AI训练集群,就有人好奇,会使用哪些数据才能喂饱如此大的模型呢?

明显Grok3模型的性能将迎来一波爆发式增长,同时马斯克会开始涉足文生视频、音频领域吗?

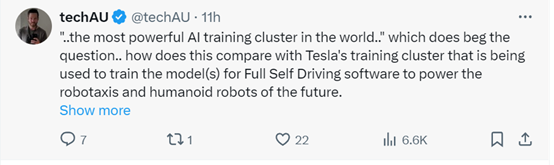

当然也有人提出了质疑,既然你现在搭建了最强AI训练集群,那么和你旗下的特斯拉和人形机器人使用的训练集群比起来如何呢?

马斯克旗下的大模型平台xAI曾在今年5月28日获得60亿美元B轮融资,估值240亿美元。主要投资者包括安德森·霍洛维茨基金、红杉资本以及来自沙特阿拉伯的王国控股公司等重量级投资机构。

在xAI的融资声明中,特别提到了与竞争对手OpenAI和Anthropic的较量。而AI算力基础设施被视为这场竞争中的关键要素,因为强大的计算能力是训练复杂AI模型的必要条件之一。xAI计划利用这笔资金来打造足以匹敌甚至超越现有行业巨头的超级计算机。

从结果导向来看,马斯克确实做到了并搭建了最强AI训练集群,期待一下xai最新大模型产品的发布。

本文素材来源马斯克社交平台,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区