Fireworks AI获5200万美元,主要提供大模型微调、推理等服务

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

7月12日,生成式AI初创公司Fireworks AI在官网宣布获得5200万美元B轮融资,估值5.52亿美元,本次由红杉资本、英伟达、AMD等投资。

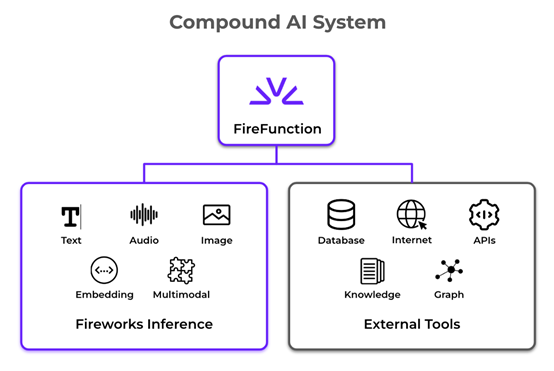

据悉,Fireworks AI是一家为企业、开发者提供大模型微调、推理、部署等服务的平台。目前,提供超过100多种先进的文本、图像、音频和多模态大模型,这些模型在延迟、吞吐量和成本等都进行了大幅度优化。

与传统方法相比,Fireworks AI将推理时间减少了12倍,与GPT-4相比减少了40倍,每天处理1400亿tokens数据,API的正常运行时间达到了99.99%。

此外,Fireworks AI可提供较小的生产级模型,能够安全私密地部署,避免了大型专有模型的非私密性和难以量身定制定制等问题。通过超快的 LoRA 微调技术,可帮助开发者快速定制模型,从数据集准备到查询微调模型仅需几分钟。这些微调后的模型可以无缝部署到用户现有的业务流程中。

目前,Cresta、Cursor 、Liner、DoorDash、Quora和Upwork等企业都在使用Fireworks AI平台进行大模型部署、推理,例如,Cursor使用Fireworks AI 提供的量身定制模型Llama 3-70b,在代码生成用例中实现了1000 tokens/sec 的效率。

在过去的三个月中,Fireworks AI推出了 FireAttention V2,这是一个基于自定义 CUDA 内核的服务堆栈,在长上下文提示的推理上快12倍,以及Firefunction-v2一个与 GPT-4o 相当的函数调用模型,效率提升2.5 倍,成本仅是其10%。

未来,Fireworks AI将会继续与Meta、英伟达、AMD、亚马逊、谷歌云等科技巨头保持合作,为用户提供效率更好、功能更完善的一站式大模型服务。

本文素材来源Fireworks AI官网,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区