仅需1分钟,文本生成高质量3D模型—Meta 3D-Gen

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

全球社交、科技巨头Meta发布了全新文生3D模型——Meta 3D-Gen。

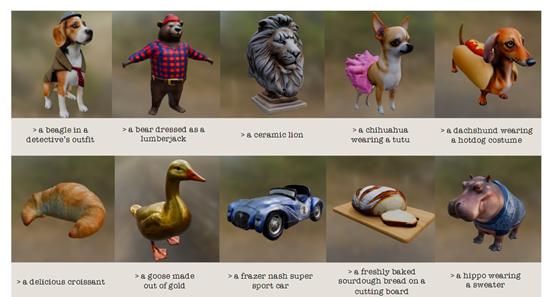

用户通过Meta 3D-Gen仅需1分钟就能生成人物、动物、道具、服饰、工业设计等不同类型的高质量3D模型。

Meta 3D-Gen不仅生成的内容是高分辨率的纹理和材质贴图,还支持物理渲染光影效果非常好,适用于游戏开发、电影制作、虚拟现实、建筑设计等领域,帮助开发人员节省大量时间。

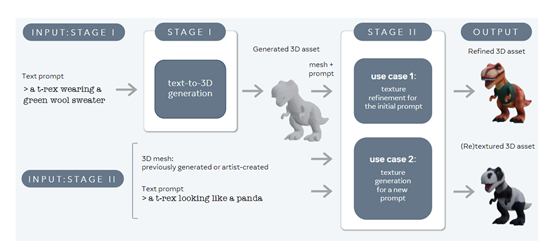

多视图到3D重建

多视图到3D重建是Meta 3D-Gen的两大核心模块之一,主要将用户输入的文本提示转换为3D空间中的具体形态,包括形状、结构、材质、纹理等。例如,“一只穿着绿色羊毛毛衣的暴龙”,需要根据文本中的绿色、毛衣、暴龙等元素解析出对应的建模。

首先,Meta使用了自研的一个多视图和多通道版本的文本到图像生成模型Emu,来生成一系列相对一致的物体视角图像。该过程就像是通过不同角度拍摄同一物体的照片,为后续的3D模型重建提供了多视角的视觉信息。

Emu模型经过精心微调,使用了合成3D数据的渲染图像,以便在视图空间中进行多视图生成,同时也在UV空间中进行生成,从而产生更优质的纹理。

然后,从这些多视角图像中提取出3D物体的初步版本,将其转换为体积空间中的表示。这是通过从多个角度的图像中重建3D形状的过程,类似于从多个快照中拼接出一个立体模型。

重建后的3D模型不仅包含了物体的形状,还附带了初步的纹理和物理渲染材质贴图,这对于在真实世界中应用非常有帮助。

为了更精准地获取3D形状,Meta 3D-Gen还使用了基于有符号距离场的优化表示法,这是一种用于描述3D形状的方法,可以计算出物体表面相对于某点的距离,对于保持形状的细节和精确性非常有效,能够在保证3D模型结构完整性和细节丰富性的同时,也确保了模型的拓扑质量

3D纹理细化

在第一阶段获取精准的3D模型之后,就需要借助3D纹理生成进一步细化、增强3D模型效果。

纹理细化是基于初始的3D模型和用户提供的文本描述,生成一系列物体的多视图图像。这些图像不仅仅是简单的渲染,还包含了物体的光照外观以及其固有色,也就是在没有外部光源影响下的物体基本颜色。

在优化的过程中,Meta 3D-Gen通过一个神经网络可将多个视角下的信息进行融合,生成一个在视觉上连贯且一致的纹理。为了增强纹理的效果,Meta 3D-Gen还内置了优化增强神经网络,输入的视图重新投影到纹理空间,生成2K、4K或更清晰的纹理细节。

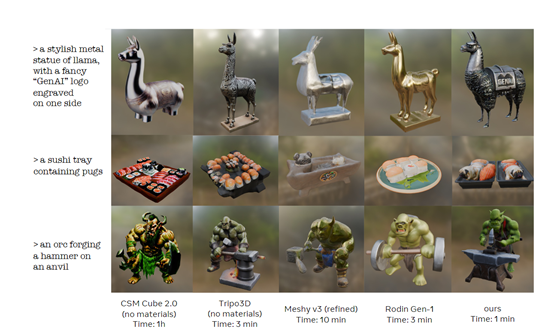

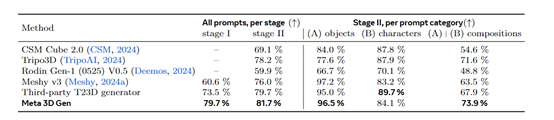

为了测试该模型的性能,研究人员将Meta 3D-Gen与CSM Cube 2.0、Tripo3D、Rodin Gen-1 V0.5和Meshy v3知名文本生成3D模型进行了综合对比。

结果显示,Meta 3D-Gen在文本语义还原、视觉质量和纹理、生成效率等关键评测指标上超越了这些模型。尤其是Meta 3D-Gen的生成效率非常高,比现有模型快3—60倍左右。

论文地址:https://scontent-eze1-1.xx.fbcdn.net/v/t39.2365-6/449707112_509645168082163_2193712134508658234_n.pdf?_nc_cat=111&ccb=1-7&_nc_sid=3c67a6&_nc_ohc=5bSbn3KaluAQ7kNvgGRfSwR&_nc_ht=scontent-eze1-1.xx&oh=00_AYC1nbp-YTq0P7189qTiXg4WAhfjVogkCEwMnJR5XJrw4Q&oe=668A5091

本文素材来源Meta 3D-Gen论文,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区