英伟达开源合成数据大模型:奖励模型,超过GPT-4 Turbo

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

6月15日,全球AI领导者英伟达(Nvidia)在官网开源了,专门用于生成合成数据的大模型Nemotron-4 340B。

开发人员通过该模型,可以快速生成医疗、金融、制造、营销等不同领域的数据,用于预训练和微调特定的大模型。

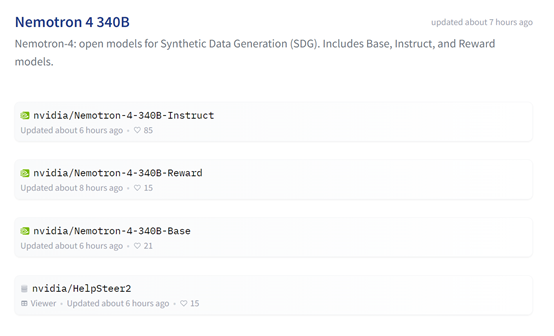

据悉,Nemotron-4 340B一共有基础模型、奖励模型和指导模型三个版本,支持RLHF(人类反馈强化学习)、LoRA(低序适配)、SFT(监督式微调)等主流高效微调方法。

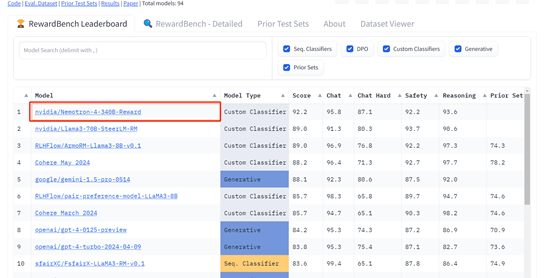

其中,奖励模型版本更是登上了huggingface的奖励模型排行榜的第一名,击败了OpenAI的GPT-4 turo、谷歌的Gemini-1.5 Pro、Cohere的may等知名厂商的产品。

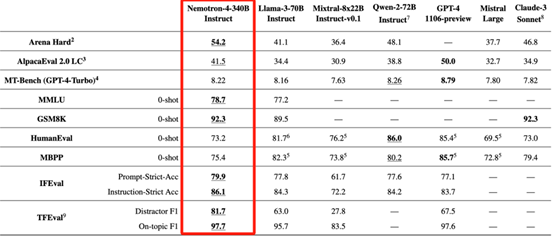

而指导模型在MMLU、GSM8K、MBPP等知名测试平台的评估数据击败了Llama-3 70B、通义千问-2-72B、Claude-3-Sonnet等知名开/闭源模型,仅次于OpenAI的GPT-4。

这也就是说,用Nemotron-4 340B生成的合成训练数据的质量非常高,这对于开发高性能大模型很有帮助。

开源地址:https://huggingface.co/collections/nvidia/nemotron-4-340b-666b7ebaf1b3867caf2f1911

此外, Nemotron-4 340B的三个版本模型可以与英伟达开源的,多模态大模型开发框架NeMo以及高效推理框架TensorRT-LLM相结合使用。

从训练数据到开发、推理框架,英伟达已经全部为开发者准备,提供了一站式全家桶服务。

NeMo是一个面向科研人员和PyTorch开发者的可扩展、原生云的生成式AI框架,专用于大语言模型、多模态模型、自动语音识别、文本转语音和计算机视觉等。用户可通过利用现有代码和预训练模型检查点,帮助您高效地创建、定制和部署新的生成式AI模型。

TensorRT-LLM是一个易于使用的Python API,专门用于开发定制大语言模型并构建TensorRT引擎,这些引擎包含了针对英伟达 GPU上高效推理的最新优化技术。

TensorRT-LLM包含了创建Python和C++运行时的组件,用于执行这些TensorRT引擎。还包括与NVIDIA Triton推理服务器集成的后端,这是一个用于提供大模型的生产级系统。

NeMo开源地址:https://github.com/NVIDIA/NeMo

TensorRT-LLM开源地址:https://github.com/NVIDIA/TensorRT-LLM

架构方面,Nemotron-4-340B使用了仅解码器Transformer架构,使用因果注意力掩码,采用旋转位置嵌入,SentencePiece分词器,以及在MLP层中使用平方ReLU激活函数。

但没有偏置项,dropout率为零,并且输入输出嵌入是未绑定的,模型还使用了分组查询注意力。

训练数据方面,Nemotron-4-340B在9万亿tokens数据上进行了预训练,主要使用了英语自然语言数据、多语种自然语言数据和源代码数据三大类。

英语自然语言数据,包括来自各种来各领域的网络文档、新闻文章、科学论文、书籍等;多语种数据包含了53种自然语言,由单语和平行语料库的文档组成;源代码数据集由43种编程语言组成,例如,Python、PHP、C#、C++、JAVA等。

训练细节方面,Nemotron-4-340B使用了768个DGX H100节点进行训练;每个节点包含8个基于NVIDIA Hopper架构的H100 80GB SXM5 GPU。每个H100 GPU在进行16位浮点(bfloat16)运算时,峰值吞吐量为989 teraFLOP/s。

模型对齐方面,Nemotron-4 340B使用了一种全新的算法——奖励感知偏好优化,主要通过使用由策略网络定义的隐式奖励来近似奖励差距。这与直接偏好优化相比,奖励感知偏好优化学习近似奖励差距可以防止过拟合难题。

此外,开发人员将很快可以在NVIDIA NIM上部署、使用Nemotron-4-340B模型,支持云服务托管非常方便。

NIM地址:https://www.nvidia.com/en-us/ai/#referrer=ai-subdomain

本文素材来源英伟达官网,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区