重磅!OpenAI发布GPT-4o,非常惊艳语音版ChatGPT!

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

5月14日凌晨,OpenAI在官网正式发布了新旗舰模型GPT-4o,可跨视频、音频、文本进行实时推理,全球生成式AI领域再次迎来历史性时刻。

OpenAI通过GPT-4o打造的语音版ChatGPT助手,可以与用户跨音频、视频进行交流,例如,让GPT-4o进行实时翻译、唱歌、做数学题、讲笑话等。简单点说吧,以后家教、翻译、秘书的饭碗都不保了。

2013年曾获得奥斯卡最佳原创剧本的电影《Her》,为我们呈现了一场人与AI的“恋情”,Her的无所不能展现出了AI强大和恐怖的一面 。

11年后,GPT-4o将这部电影变成了现实,人人都可以拥有一个Her。

GPT-4o功能展示

OpenAI对GPT-4o的功能进行了大量展示,这里「AIGC开放社区」就选几个有代表性的吧。例如,通过手机与GPT-4o视频,让其解读一下你的想法。

首先,OpenAI的员工拿着手机拍摄了周围的场景,很快GPT-4o便给出周围的环境描述。接着员工让GPT-4o猜测他今天要做什么的时候,它说可能会与OpenAI有关,开一个发布会之类的。

当员工说出这个发布会与“你”有关时,它的回答有点让人觉得恐怖,居然会像人一样表现出惊讶和停顿,这是以往任何语音助手都不具备的技术特征。

OpenAI总裁兼联合创始人Greg Brockman让两个GPT-4o语音助手互相对话并唱歌。

一位父亲希望GPT-4o可以辅导他的儿子做一道很难得数学题。它没有像以往的ChatGPT一下子把所有答案都给出来,而是像家教一样,一句一句的用引导的方式告诉他应该如何解答这道题。

当「AIGC开放社区」看到这里时也为那些辅导老师捏了一把汗,估计在进化几次连家教的饭碗也不保了。

和GPT-4o相处久了,应该向它介绍点朋友吧。这不OpenAI展示了GPT-4o社牛的一面,直接解读了一条宠物狗。

当你想与法国人、塞尔维亚人、匈牙利人进行对话时怎么办?只能用翻译软件吧,但是那种传统的太慢了不太适合交流。通过GPT-4o可以做到实时翻译了,当你说完一句话时,它已经帮你翻译好了并且是语音输出的。

怎么样,看完这几个案例对GPT-4o有何感受,是不是和电影中的Her几乎差不多了?更惊喜的是OpenAI宣布免费开放使用,即便你不是付费用户也没问题。

GPT-4o测试数据

GPT-4o是一个多模态模型,可以在一个神经网络中输入和输出文本、视频、音频3种数据格式。

根据OpenAI给出的官网评测显示,GPT-4o的语音响应可以短至232毫秒,平均响应为320 毫秒。GPT-4o的英语文本和代码能力和 GPT-4 Turbo 的性能差不多。

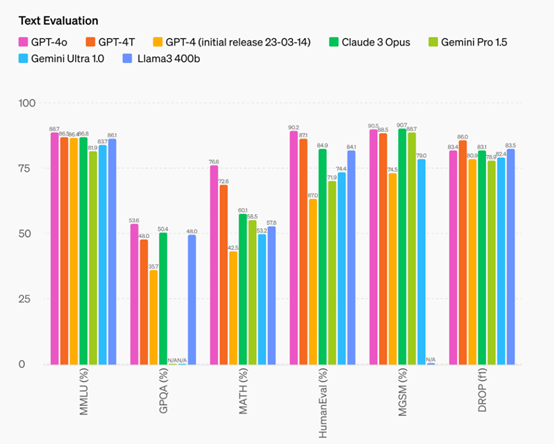

GPT-4o在MMLU的评测中创下了88.7% 的新高分,超过了Claude 3 Opus、Gemini Pro 1.5、Gemini Ultra 1.0等目前市面上著名大模型。

GPT-4o的音频ASR性能比 Whisper-v3 显着提高了对所有语言的语音识别能力,特别是对于那些非常稀少的小语种,并且音频的翻译能力超过了谷歌的Gemini。

目前,GPT-4o的文本和图像功能已经在ChatGPT中开放使用,免费注册用户也可以体验该功能。

开发人员通过API可以访问GPT-4o 的文本和视觉功能。与GPT-4 Turbo相比,GPT-4o 速度提高了2倍价格低了50%,并且极大降低了tokens限制。

未来几周内,OpenAI会在ChatGPT Plus中推出新版语音模式GPT-4o的alpha版。让我们期待一下更强的Her出现吧。

本文素材来源OpenAI官网,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区