英伟达发布GB200 NVL72,将万亿参数大模型推理效率提升30倍

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

3月19日,英伟达召开了“2024GTC”大会,在会上重磅发布了新一代AI专用GPU GB200 NVL72。

GB200 NVL72是一款专门面向万亿参数大模型训练、推理的产品,例如,在训练MoE(专家混合模型)时,需要多个子模型之间分配计算负载,并在数千个GPU上进行训练。这需要超高的并行计算、快速存储和高性能通信以及在大规模GPU集群下才能完成。

与上一代的H100 GPU相比,GB200 NVL72可以将训练效率提升4倍,数据处理提升6倍,实时推理效率提升30倍!

GB200 NVL72架构介绍

GB200 NVL72的核心架构是NVIDIAGB200 Grace Blackwell Superchip,主要通过NVLink-Chip-to-Chip(C2C)接口连接两个高性能的NVIDIA Black wellTensor CoreGPU和NVIDIA GraceCPU,提供900GB/s的双向带宽。

在NVLink-C2C的帮助下应用程序可以对统一内存空间进行一致访问。这极大简化了编程,并支持万亿参数的多模态大模型,对大规模模拟和3D数据生成模型的更大内存需求。

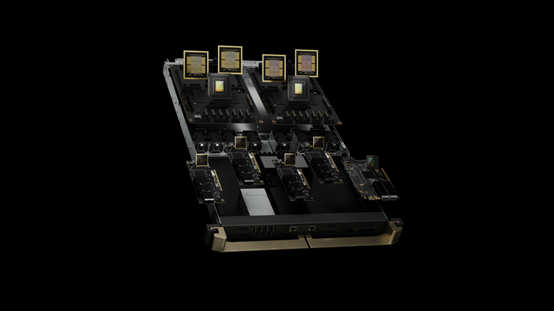

GB200计算托盘

GB200计算托盘

GB200的计算托盘基于新的NVIDIAMGX设计,这包含两个GraceCPU和四个BlackwellGPU。

GB200具备冷板和液冷连接、PCIegen6支持高速网络以及NVLink连接器用于NVLink电缆插卡。GB200计算托盘提供80petaflops的AI性能和1.7TB的快速内存。

NVIDIAGB200NVL36和NVL72

GB200支持在NVLink域中使用36和72个GPU。每个机架基于MGX参考设计和NVLink交换系统承载18个计算节点。它以GB200NVL36配置提供,一个机架内有36个GPU和18个单个GB200计算节点。

NVLink交换系统

NVLink交换系统

GB200 NVL72配置为一个机架内有72个GPU和18个双GB200计算节点,或者在两个机架内配置72个GPU和18个单个GB200计算节点。

GB200 NVL72通过使用铜电缆模块密集地打包和互连GPU,以实现操作简便。同时采用了液冷系统设计,能够降低25倍的成本和能耗。

第五代NVLink

英伟达的SerDes推动了GPU到GPU通信的创新和业界领先的高速低功耗,主要通过引入NVLink以加速高速多GPU通信。

2014年英伟达推出了第五代NVLink,速度为160GB/s,比第一代快12倍。NVLinkGPU到GPU通信在扩展AI和HPC中的多GPU性能方面发挥了重要作用。

NVIDIAGB200 NVL72使用了第五代NVLink,可在单个NVLink域中连接多达576个GPU,总带宽超过1PB/s,快速内存可达240TB。

每个NVLink交换机托盘提供144个100GB的NVLink端口,因此这9个交换机完全连接72个BlackwellGPU上每一个的18个NVLink端口。

每个GPU都是革命性的1.8TB/s双向吞吐量,是PCIeGen5带宽的14倍以上,为当今最复杂的超万亿参数的大型模型提供无缝高速通信。

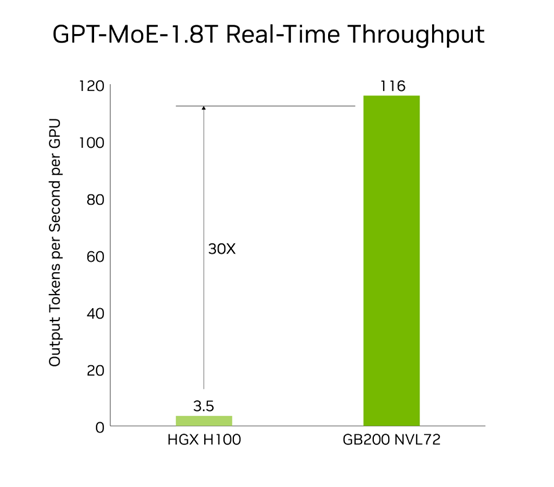

GB200 NVL72性能展示

GB200 NVL72在大模型训练、推理方面,展现出了前所未有的超强性能。在训练方面,与上一代H100相比,通过32k GB200 NVL72 训练1.8万亿参数的GPT-MoE 模型性能可提升4倍。

推理方面,GB200 NVL72借助新一代 Tensor Core创新技术,以及引入了 FP4 精度和第五代 NVLink 等诸多技术,与H100相比,整体效率提升了30倍。

GB200 NVL72数据处理

大数据分析帮助组织释放洞察力并做出更明智的决策。组织不断大规模生成数据,并依靠各种压缩技术来节省存储成本。

为了在 GPU 上高效处理这些数据集,Blackwell 架构引入了硬件解压缩引擎,该引擎可以大规模本地解压缩压缩数据并加速端到端的分析管道。解压引擎原生支持解压使用 LZ4、Deflate 和Snappy 压缩格式压缩的数据。

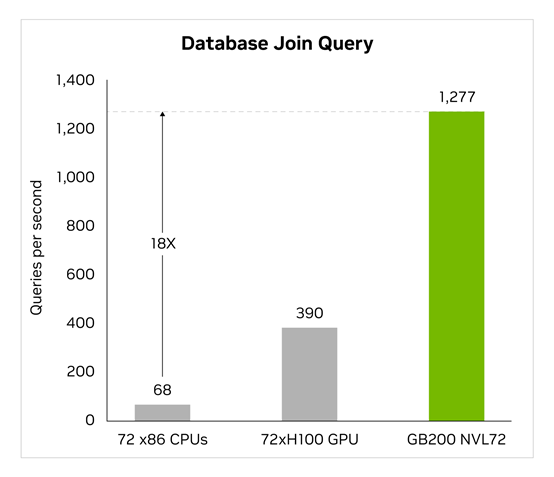

解压缩引擎加速内存绑定的内核操作,GB200 NVL72提供高达 800 GB/s 的性能,使 Grace Blackwell 在查询基准测试中的执行速度比 CPU (Sapphire Rapids) 快 18 倍,比 H100快 6 倍。

GB200 NVL72凭借高达 8 TB/s 的高内存带宽和 Grace CPU 高速NVlink 芯片到芯片,该引擎加快了数据库查询的整个过程,使组织在快速获得数据见解的同时大幅度降低数据存储、处理成本。

本文素材来源英伟达官网,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区