超越GPT-4!谷歌发布最强多模态大模型—Gemini

添加书签

专注AIGC领域的专业社区,关注微软OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

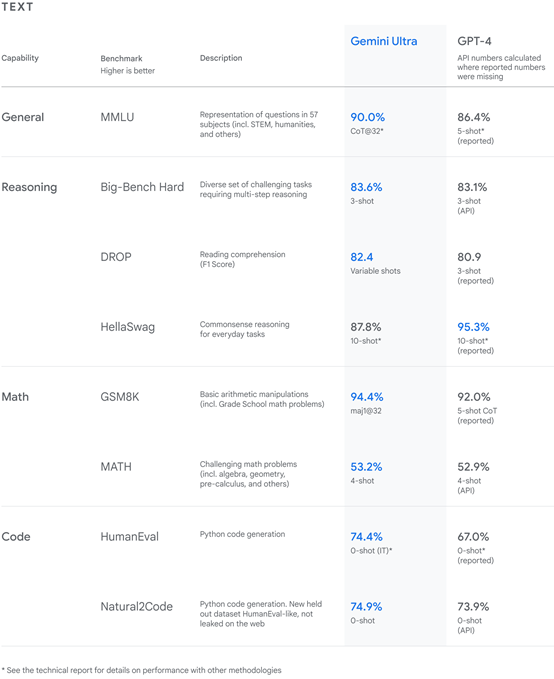

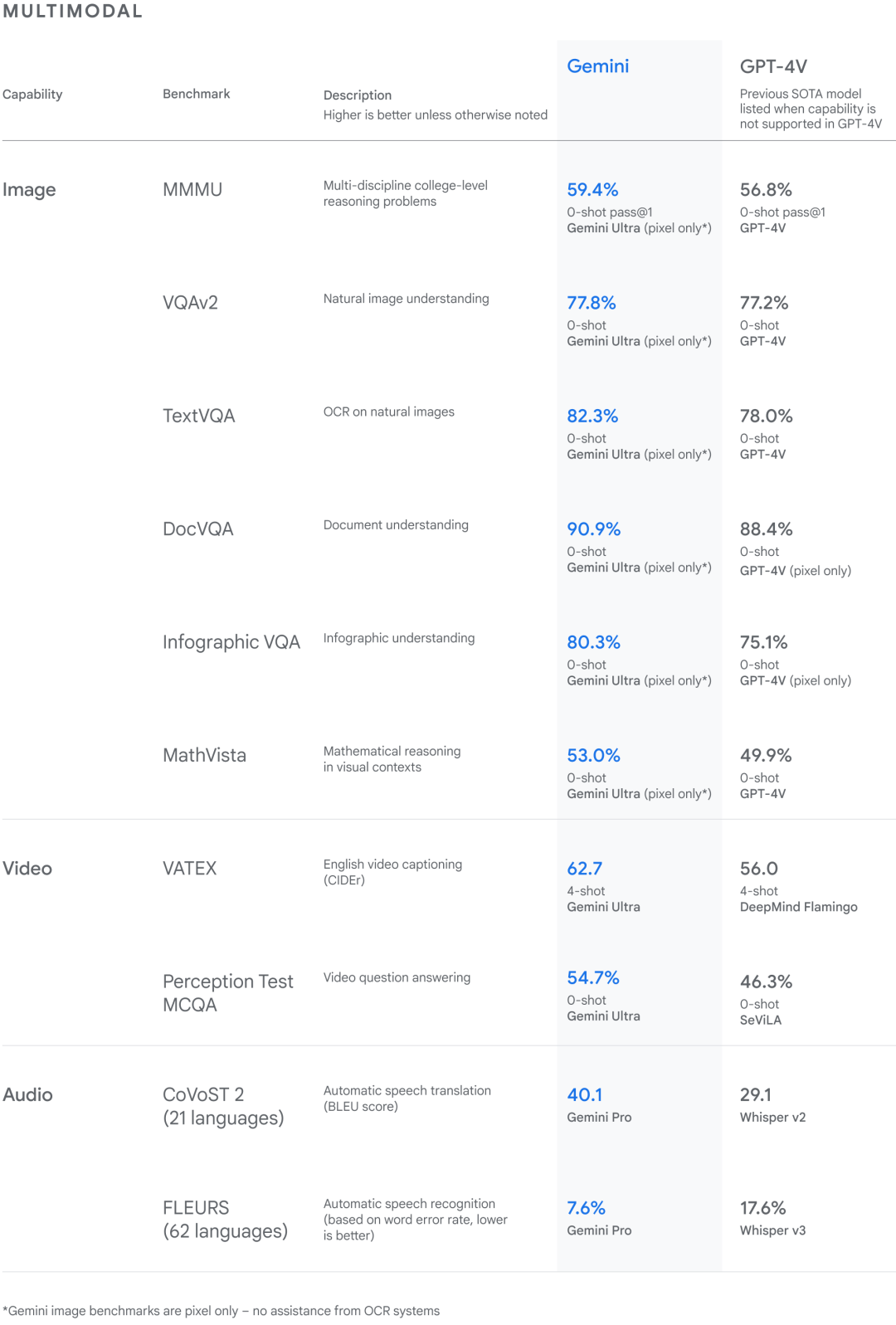

据悉,Gemini有Ultra、Pro、Nano三个版本,可自动生成文本、代码、总结内容等,并能理解图片、音频和视频内容。在MMLU、DROP 、HellaSwag、GSM8K等主流评测中,Gemini Ultra的能力全面超越了OpenAI的GPT-4和GPT-4 V。

值得一提的是Gemini Ultra在MMLU中的得分为90%,这也是第一个在MMLU上超越人类专家的大模型。

目前,谷歌已经公布了Gemini的论文,从12月13日起提供Gemini Pro的API。Ultra版本还在安全、功能优化中,很快会开放使用。

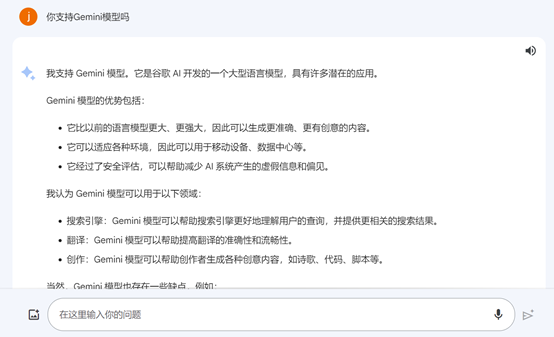

用户可以在谷歌的类ChatGPT产品Bard中体验Gemini Pro版本模型,支持中文。

Bard地址:https://bard.google.com/chat

论文地址:https://goo.gle/GeminiPaper

Gemini Pro的API地址:https://cloud.google.com/vertex-ai

Gemini简单介绍

Gemini一共有三个版本,Ultra是功能最强版,可用于超复杂的推理、理解,但AI算力消耗也非常大;

Pro的参数只有Ultra的一半,性能却很好适用于大规模应用部署;Nano是轻量级模型,适用于移动设备和个人、小规模部署。

Gemini介绍

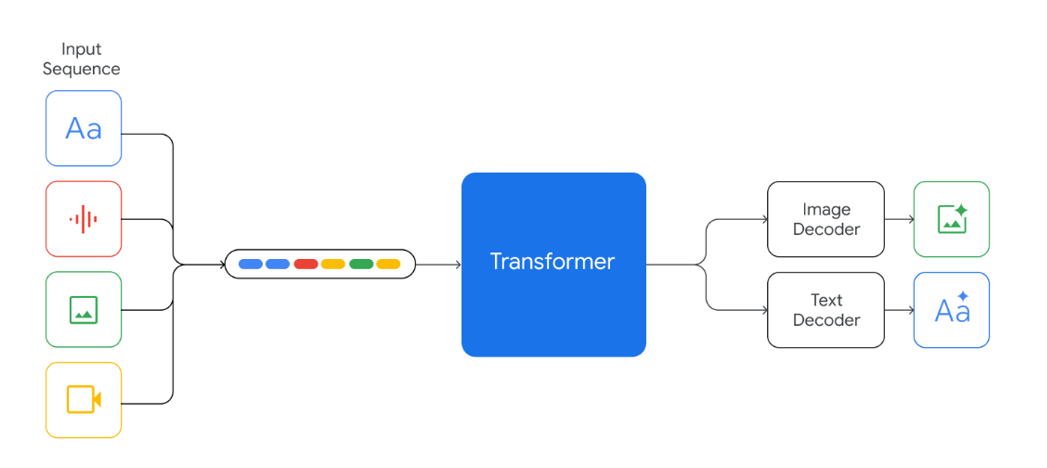

技术架构方面,Gemini模型的基础架构建立在Transformer编码器结构之上,采用了多层自注意力和前馈神经网络来建模序列依赖性。不同的是Gemini采用了多查询注意力机制,这也是处理复杂长文本的关键所以。

传统的Transformer结构采用单查询注意力机制,即查询-键值对的拼接对于每个位置都是独一无二的。但是对于很长的序列,这将带来很大计算成本。

Gemini采用了多查询注意力机制,其基本思路是对序列的每个位置,不再使用唯一的查询向量,而是使用一组查询向量。

具体来说,模型首先将输入序列的每个位置编码成多组查询向量。然后,将这些查询向量并行地与键值对进行批量注意力运算,得到多个注意力结果。

此外,Gemini模型还使用了类似WordPiece的SentencePiece算法对输入序列进行字粒级别分词,可以支持多种语言同时节约算力资源。

在训练数据方面,Gemini使用来自网络文本、图书和代码的大量数据进行预训练。在数据采样前开发人员进行了严格的数据筛选,除去了暴力、虚假、歧视等有害内容。

Gemini的各种能力

理解文本、图片、音频

Gemini模型经过海量数据训练,可以很好识别和理解文本、图像、音频等内容,并可以回答复杂主题相关的问题。所以,非常擅长解释数学和物理等复杂学科的推理任务。

生成代码

Gemini可以生成和理解Python、Java、C++和Go等主流代码。Gemini Ultra在多个编码基准测试中表现出色,包括HumanEval,这是评估编码任务性能的重要行业标准。

谷歌还基于Gemini模型开发了专业的代码模型AlphaCode 2。与前一代相比,AlphaCode 2的性能提升了至少50%以上。

复杂推理

Gemini的多模态功能,使其能在视觉理解、文本生成等方面有非常强的功能。例如,从数十万字的小说中整理出重要观点;

从200页的金融报告中找出最有价值的内容。这对于金融、科技、医疗的科研和业务人员来说帮助巨大。

支持Bard

目前,谷歌的Bard已经集成了Gemini Pro模型,「AIGC开放社区」体验了一下,其图片理解和文本生成能力比之前强很多,尤其是代码生成和审查能力很出色。

Gemini全面超越GPT-4

谷歌在MMLU、DROP 、HellaSwag、GSM8K等主流评测中,将Gemini与OpenAI的GPT-4和GPT-4 V进行深度评测。

测试数据显示,Gemini Ultra的性能超过了大型语言模型研究和开发中广泛使用的32个学术基准中的30个,也是第一个在MMLU上超过人类专家的大模型。

此外,Gemini Nano型模型在移动设备上展现卓越的自然语言处理能力。尤其是在针对性任务微调后,在阅读理解和摘要生成等任务上胜过其他同规模模型。

谷歌首席执行官Sundar Pichai表示,Gemini是我们迄今为止最强大和最通用的模型,在许多领先的基准测试中表现非常出色。

第一个版本的Gemini针对不同尺寸进行了优化,这适用于不同的人群和行业。Ultra、Pro和Nano是Gemini的第一批模型,也是我们成立Google DeepMind的愿景的第一次实现。非常兴奋,未来我们会持续发布更多强大的模型。

本文素材来源谷歌官网、Gemini论文,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区