将ChatGPT与物理机器人结合,波士顿动力开发了一只怪物!

添加书签

专注AIGC领域的专业社区,关注微软OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

10月27日,全球顶级机器人开发商波士顿动力(Boston Dynamics)在官网展示了一项新的研究,通过将ChatGPT、Spot以及其他AI模型相结合,开发了一种会说话的导游机器狗。

据悉,该机器狗能够根据文字、语音提示与人类进行交谈,同时提供了视觉问答功能,可以分析摄像头拍摄的画面,自动生成图像说明。

波士顿动力表示,ChatGPT等大语言模型展现出了强大的控制和输出能力,这让他们大受启发,可以用于控制物理机器人的行为和决策功能。例如,输入一些特定景点数据、图片等,可让机器人提供逻辑清晰、条理分明的导游功能。

此外,这也增强了物理机器人的拟人化能力,如为你讲一个冷笑话,做一个逗你开心的滑稽动作。如果采用传统的发方法,将是一件非常困难的事情。

导游机器狗展示

导游机器狗技术原理

波士顿动力使用了自研的四足机器人Spot作为物理机器人框架,实现了行走、监控、导航、扫描等基础功能。

为了能让机器狗说话与人类互动,研发人员为其配备了Respeaker V2扬声器,这是一个带有 LED 的环形阵列麦克风,可通过USB将其连接到Spot的EAP 2实现数据传输。

1)Spot EAP 2)扬声器3) 蓝牙音箱4)点臂和夹具相机

1)Spot EAP 2)扬声器3) 蓝牙音箱4)点臂和夹具相机

使用了一台电脑作为机器狗的控制大脑,并通过Spot SDK与其实现数据交互。为了让机器狗具备拟人化动作,例如,点头,伸脖子等,使用了Spot的点臂和夹具相机。

用ChatGPT让机器狗说话

物理硬件环境搭建完成后,为了使机器狗具备对话功能,研发人员使用了GPT-3.5和GPT-4与Spot SDK相结合,并进行了简单的指令微调,让机器狗具备了初级导游判断和对话功能。

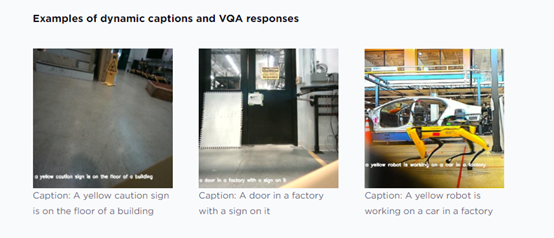

接下来,为了让Spot与人类和环境进行交互,集成了VQA和语音转文本软件。同时将机器人的抓手摄像头和前置机身摄像头输入BLIP-2,并以视觉问答模式(例如“这张图片有什么有趣的地方?”等简单问题)或图像字幕模式运行它。

该过程大约每秒运行一次,结果将直接输入到提示中。

为了让机器狗可以实现“听”的功能,研发人员将麦克风数据分块输入到OpenAI的语音模型Whisper中转换为英文文本。

为了让机器狗能与人类实现对话,需要将人类的语音指令转换成文本用于提示ChatGPT,因此还需要一个转换工具。开发人员在尝试了多种工具后,决定使用了云服务ElevenLabs。

实验中的惊奇现象

在多个测试对话过程中,研发人员发现了一个令人惊奇的现象,机器狗好像具备了简单的自我决策能力。

例如,向机器狗询问Marc Raibert(波士顿动力执行董事)是谁时?它回答:“我不知道他是谁,让我们去服务台问一问吧。”

到了服务台,机器狗继续向服务人员询问Marc Raibert是谁?

当研发人员提问:你的父母是谁?机器狗走向了Spot V1和Big Dog的展示区,并认为这些机器人是它的父辈们。实际上,它们之间确实有关联。

机器狗还展现出了有趣的一面,可以主动向路人询问,周围是否有神秘的生物。

波士顿动力表示,未来还会持续优化该产品的功能。ChatGPT与实体机器人的相结合,为大语言模型实现物理化落地打开了大门,可以在导游、娱乐、物流、陪伴等领域得到广泛应用。

关于波士顿动力

波士顿动力(Boston Dynamics)成立于1992年,总部位于马萨诸塞州波士顿。起初是麻省理工学院(MIT)的一个分支机构,后来发展成为一家独立的公司。

波士顿动力以开发高度先进、灵活且具有实用性的机器人而闻名,其产品在工业、研究和消费领域都有应用,主要代表机器人包括:BigDog、Atlas、Spot、Handle等。

本文素材来源波士顿动力官网,如有侵权请联系删除

END